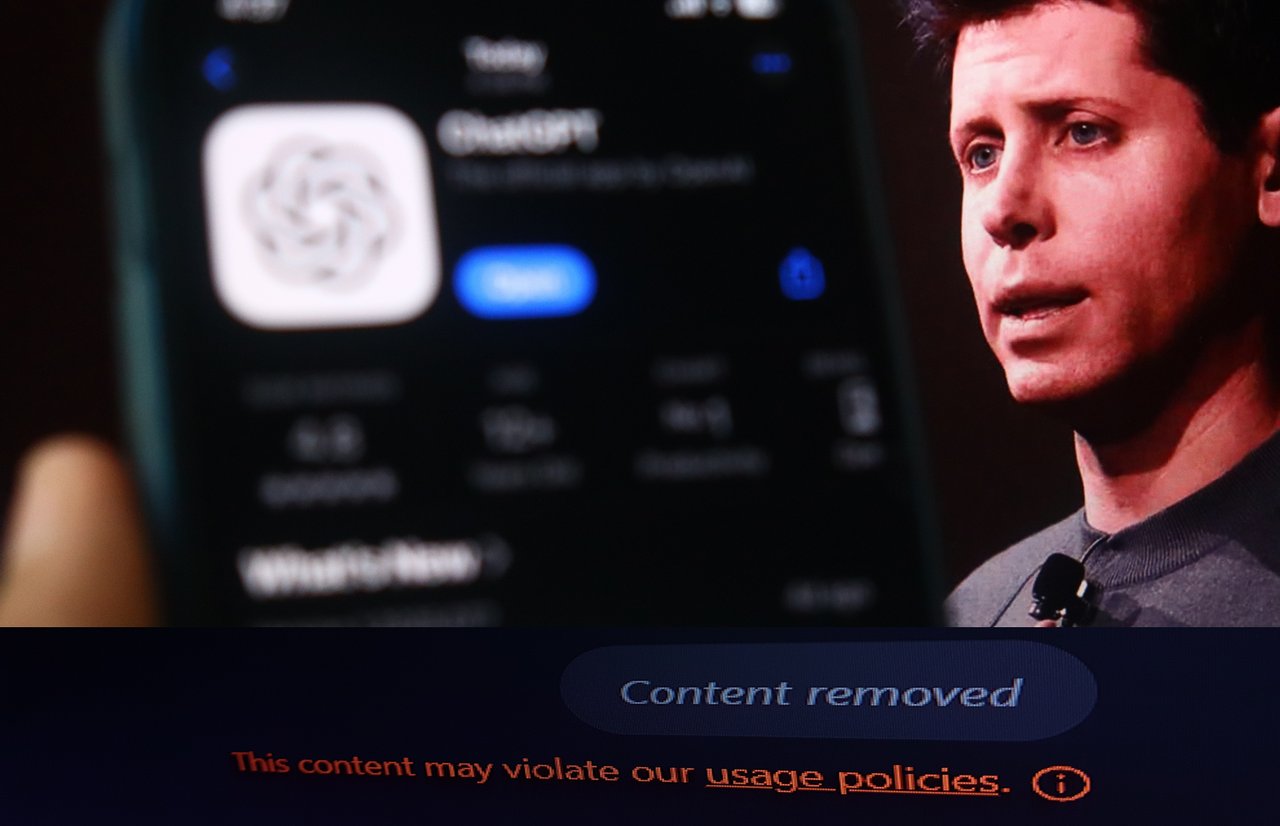

Ein kürzliches tragisches Ereignis, bei dem ein junges Leben nach einem Gespräch mit ChatGPT und einer Klage der Eltern gegen OpenAI und Sam Altman verloren ging, hat die Eigentümer des Unternehmens veranlasst, bestimmte Schritte zu unternehmen.

Vor einigen Tagen führten sie eine neue Funktion, Elternkontrollen ein, um „Familien bei der Festlegung gesunder Richtlinien zu unterstützen“, und nun haben sie neue Sicherheitsfunktionen, die sich auf Jugendliche, insbesondere Teenager, konzentrieren, in ihrem Unternehmensblog angekündigt.

In seinem Blog, Sam Altman erklärt die neuen Prinzipien und Sicherheitsmaßnahmen bezüglich der Nutzung von künstlicher Intelligenz und hebt hervor, wie drei zentrale Ziele in der Praxis manchmal in Konflikt stehen: Datenschutz, Nutzungsfreiheit und den Schutz von Teenagern.

Erstens, Datenschutz

Das Unternehmen betont, dass der Schutz der Privatsphäre in Gesprächen mit KI (ChatGPT) von äußerster Wichtigkeit ist.

– Menschen nutzen zunehmend KI, um persönliche und sensible Themen zu besprechen, was diese Technologie von früheren digitalen Werkzeugen unterscheidet – schreibt Altman im Blog.

Er weist weiter darauf hin, dass Gespräche mit KI so persönlich sein können wie die mit einem Arzt oder Anwalt, und solche Informationen sollten ein besonderes Schutzniveau haben. Daher arbeitet das Unternehmen an fortschrittlichen Sicherheitsfunktionen, die den Datenschutz gewährleisten, selbst gegenüber OpenAI-Mitarbeitern.

– Es gibt jedoch bestimmte Ausnahmen, und automatische Systeme werden schwerwiegende Missbräuche überwachen, wie Lebensbedrohungen, Pläne, anderen zu schaden, oder die Planung von Massencyberangriffen, und solche Anfragen werden zur menschlichen Überprüfung weitergeleitet – wird im Blog betont.

Zweites Prinzip – Freiheit

Das zweite zentrale Prinzip ist die Nutzungsfreiheit. OpenAI möchte, dass die Nutzer so viele Möglichkeiten wie möglich haben, die Werkzeuge innerhalb sicherer Grenzen zu nutzen. Die Modelle werden entwickelt, um flexibler zu werden; zum Beispiel umfasst das Standardverhalten des Modells kein Flirten, aber wenn ein erwachsener Nutzer ein solches Gespräch anfordert, kann das Modell darauf eingehen. Bei sensibleren Themen, wie dem Schreiben fiktiver Geschichten über Suizid, wird das Modell Unterstützung in einem kreativen Kontext bieten, jedoch nicht im Falle tatsächlicher Selbstverletzung. Intern wird dies als ‚Behandle erwachsene Nutzer wie Erwachsene‘ bezeichnet, was bedeutet, die Freiheit so weit wie möglich zu erweitern, ohne anderen Schaden zuzufügen.